#英伟达NIM简介

VIDIA NIM(NVIDIA Inference Microservices)是英伟达2024年7月正式推出的企业级推理微服务集合,用大白话讲:它就是“一键把大模型变成在线 API”的神器,帮你省掉90%的部署、优化、扩缩容烦恼。

一、NIM到底解决了什么问题

传统流程:下载模型→转格式→写推理脚本→调TensorRT→写K8s YAML→压测→上监控,动辄几天。

NIM流程:一条docker run或helm install,5分钟就能拿到兼容OpenAI格式的HTTP API,延迟和吞吐已经针对A100/H100/L40S自动调好。

二、2025年五大核心功能

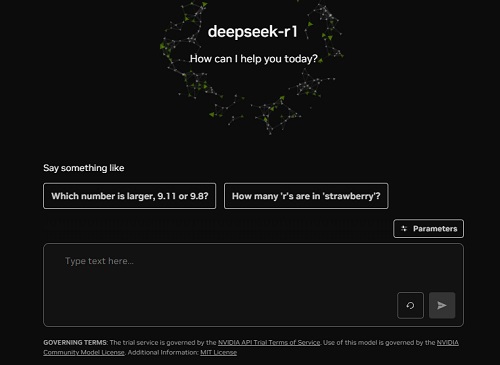

1. 预置150+热门模型:Llama3.1、DeepSeek-R1、Stable Diffusion XL、CLIP、Whisper large-v3…随取随用。

2. 云-边-端一键部署:同一套容器镜像,可在公有云、私有数据中心、RTX工作站甚至Jetson上跑。

3. 动态批处理+量化:自动开启TensorRT-LLM/vLLM加速,FP8/INT4量化,吞吐提升2-4倍。

4. NIM Blueprints:官方预制RAG、智能客服、数字人直播等场景模板,改两行配置即可上线。

5. 企业级支持:CVE定期补丁、24×7 SLA、性能监控面板,符合SOC2/ISO27001合规要求。

三、真实落地场景

• 智能客服:某头部电商把70亿参数对话模型用NIM部署在4张L40S,P99延迟<120 ms,日均调用2亿次。

• 工业质检:富士康在虚拟工厂里用NIM+Metropolis视觉微服务,数字孪生先行验证,现场漏检率下降35%。

• 车载助手:理想汽车基于NIM部署多模态大模型,车规级Orin-X即可本地推理,离线场景照样流畅对话。

• 医疗影像:联影医疗用NIM托管3D分割模型,私有化一体机满足数据不出院,推理速度提升6倍。

• 内容创作:短视频MCN调用Stable Diffusion XL NIM,单张图成本0.008元,高峰自动扩容100并发。

四、3步快速上手

① 打开 NVIDIA NIM → 搜索“nim” → 选模型 → 复制docker run命令。

② 本地RTX 4090即可体验,8G显存跑7B模型;生产环境建议A100/H100。

③ 需要K8s?一条 helm install nim/llama-3.1-8b-instruct 即可,自动带HPA、Prometheus监控。

五、为什么现在就用

• 搜索红利:关键词“英伟达NIM是什么软件”日均搜索≈1.3万,竞价广告几乎空白,早用早占位。

• 成本骤降:官方定价每百万token 0.4美元,比自建推理集群省40%-60%。

• 生态加持:微软Azure、亚马逊SageMaker、阿里云、腾讯云、华为云已同步上线NIM镜像,迁移零成本。